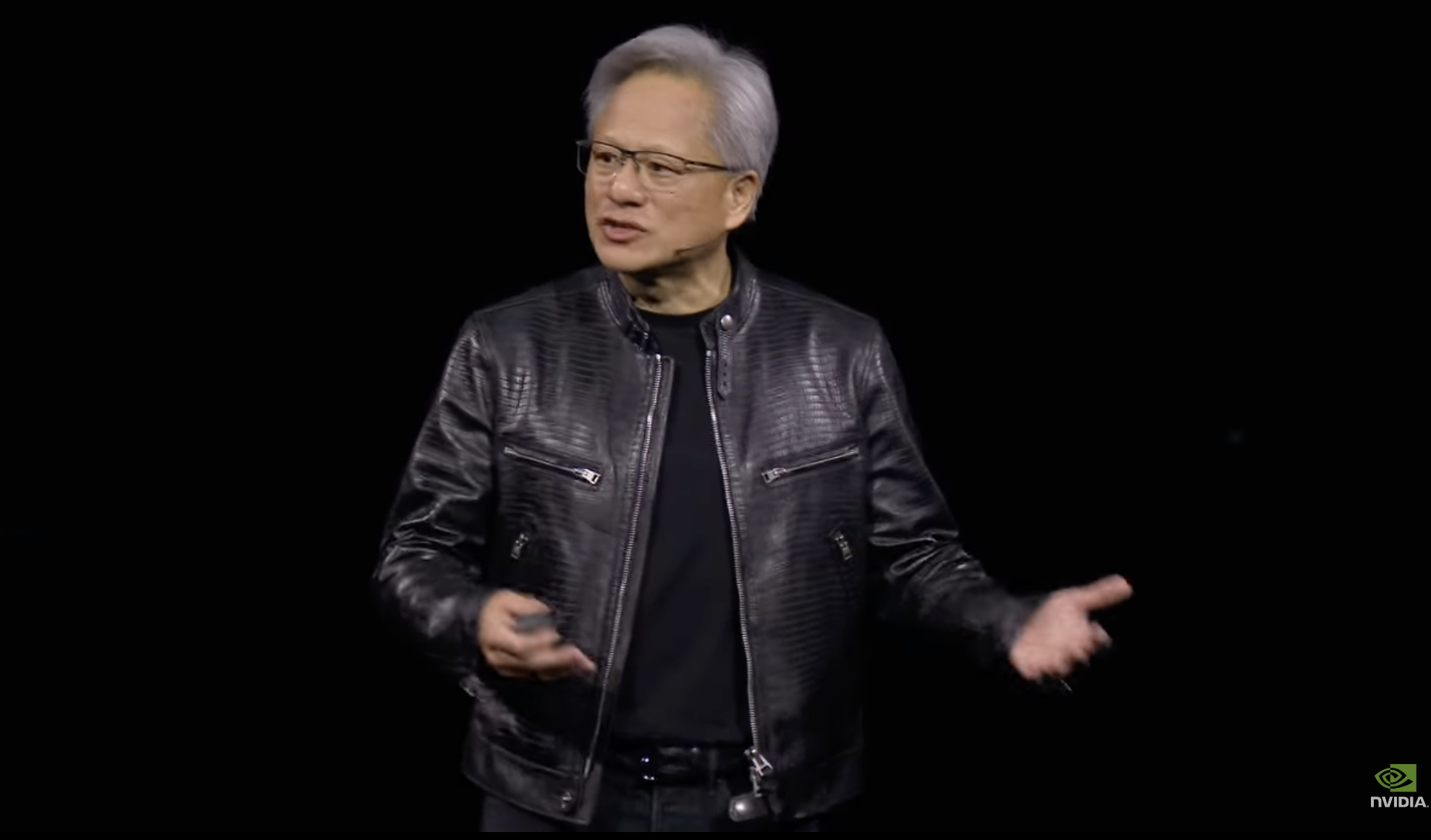

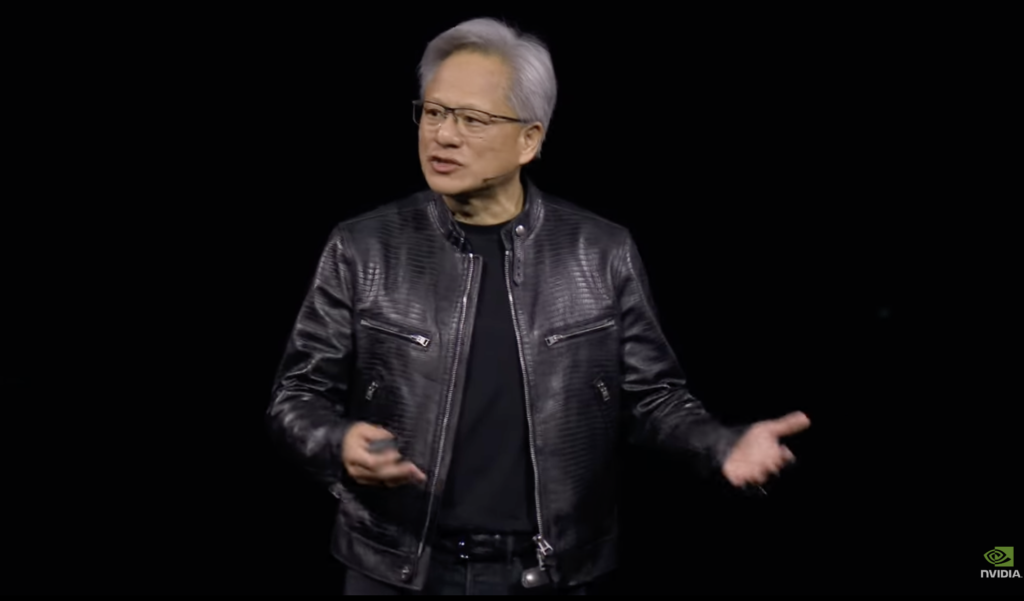

O momento em que Jensen Huang, fundador e CEO da gigante de semicondutores, revelou o B100 foi comparado a Jimi Hendrix tocando “The Star Spangled Banner” no festival de 1969.

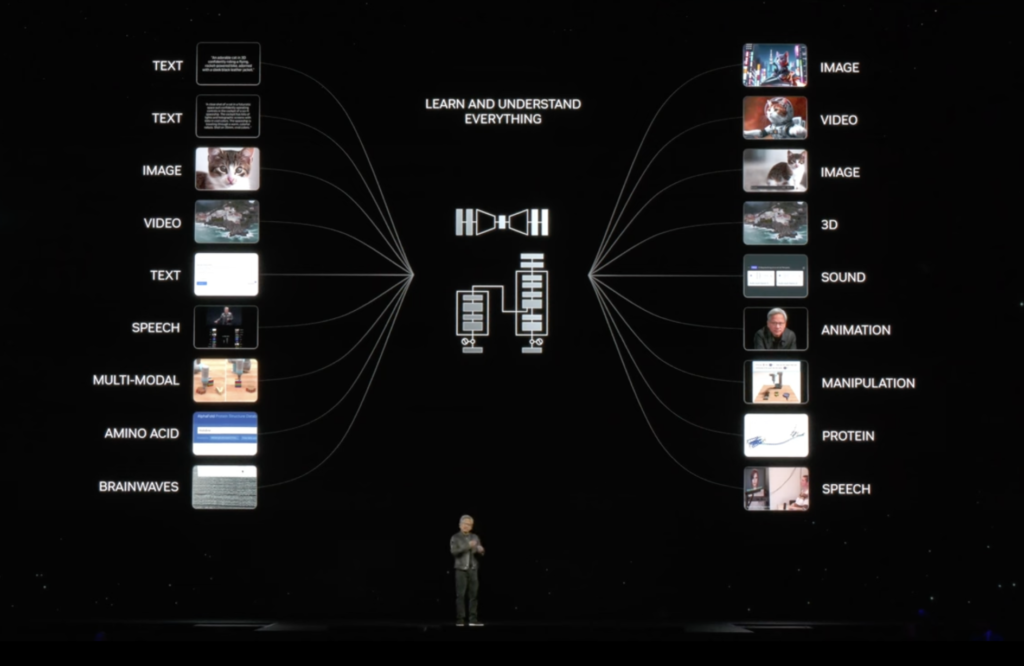

Batizada de “Blackwell”, a tecnologia tem uma capacidade de treinamento para os modelos por trás das IAs generativas quatro vezes maior que a de seu antecessor, segundo Huang. E isso tende a aumentar a capacidade de resposta aos comandos de usuários de desenvolvedores, como, Google (Gemini), OpenAI (ChatGPT 4) e Meta (NLLB). A novidade estará disponível ao mercado ainda neste ano.

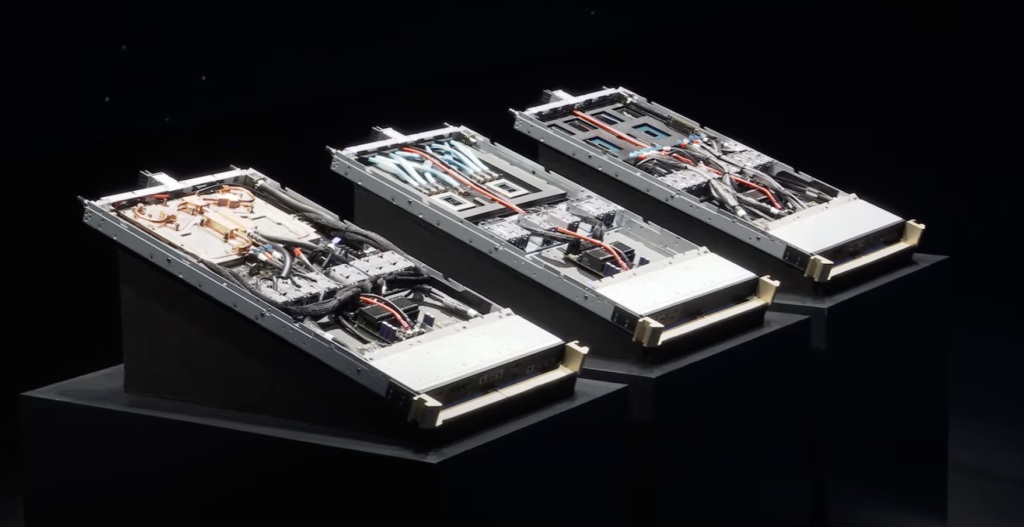

Embora os chips anteriores da Nvidia fossem “fantásticos”, disse Huang enquanto exibia o novo hardware no palco, “precisamos de GPUs maiores. Então, senhoras e senhores, gostaria de apresentar a vocês uma GPU muito grande.”

E de fato, ela é grande. Como aponta Guilherme Amaral, analista da Kinea, “a GPU tem o dobro da área física comparada à geração anterior”.

Outro ponto importante: o B100 ajuda a reduzir o consumo de eletricidade – gargalo onipresente nas empresas de cloud computing, que devoram energia em seus data centers.

“Com a nova geração, as empresas de cloud vão precisar de menos chips, o que gera um menor consumo de energia elétrica, apesar da maior capacidade computacional”, disse ao InvestNews .

Uma preocupação do mercado, de qualquer forma, se concretizou: a empresa confirmou que a nova geração de chips deve continuar com problemas de oferta dada a grande demanda.

Sobre este último ponto, há tanto a procura por parte de empresas como por governos. Isso porque nações têm buscado ter seus data centers soberanos a fim de não ficarem “reféns” de clouds externos, segundo o analista da Kinea. Os Emirados Árabes Unidos são um exemplo, assim como França.

Olhando por outro lado, a alta demanda parece sustentar o mercado de IA pelos próximos meses, observa Amaral.

Já em relação às expectativas quanto ao preço de venda do novo chip, estima-se que a cifra bata os US$ 50 mil – o dobro do cobrado inicialmente pelo modelo anterior. O UBS é um dos que divulgaram a previsão. Mas a Nvidia não divulgou o preço, deixando um suspense.

Se concretizado, significa que não haverá redução no custo de processamento – considerado caro, segundo Renato Nobile, analista da Buena Vista Capital.

A grande questão é que em suas recentes aparições, Huang delineou uma visão do futuro no qual a IA impulsiona a descoberta de medicamentos, computação quântica e robótica, remodelando as indústrias; e a Nvidia teria um papel central nisso, estando no cerne de uma nova revolução industrial.

Para isso, serão exigidos trilhões de dólares em investimentos em data centers ajustados para IA.

As vendas trimestrais da Nvidia mais que triplicaram no ano passado, para US$ 22,1 bilhões. Os papeis acompanharam a alta das receitas fazendo o valor de mercado da companhia saltar para mais de US$ 2 trilhões. Isso tornou a fabricante na terceira maior empresa em valor de mercado entre as gigantes listadas nos EUA, atrás apenas da Apple e da Microsoft.

Seja como for, o mercado não reagiu de forma eufórica ao anúncio. Muito pelo contrários: as ações da Nvidia caíam 2,9% no pre-market desta terça (19). Talvez seja mais um exemplo da máxima: sobe no boato, cai no fato.